package Yishikeji.Hbase.Admin.Hbase;

import java.io.InputStream;

import java.net.URL;

import java.net.URLConnection;

public class HdfsClusterTest {

public static void json() throws Exception{

//参数url化

// String city = java.net.URLEncoder.encode("北京", "utf-8");

//拼地址

// String apiUrl = String.format("https://www.sojson.com/open/api/weather/json.shtml?city=%s",city);

String apiUrl = String.format("http://node003:8088/ws/v1/cluster/scheduler");

// String apiUrl = String.format("https://www.sojson.com/api/qqmusic/8446666");

//开始请求

URL url= new URL(apiUrl);

URLConnection open = url.openConnection();

InputStream input = open.getInputStream();

//这里转换为String,带上包名,怕你们引错包

String result = org.apache.commons.io.IOUtils.toString(input,"utf-8");

//输出

System.out.println(result);

}

public static void main(String[] args) {

HdfsClusterTest httpGetData =new HdfsClusterTest();

try {

httpGetData.json();

} catch (Exception e) {

e.printStackTrace();

}

}

}

分治法

golang

云笔记

孤立点

需求分析

无人机

土地分类

三十

性能测试

二分

流程图

Exchanger

信息系统综合测试与管理

信息系统项目管理师

运动场地预约

均线策略

async/await

解压

POP

接口优化

java http返回的xml格式转成json格式

news/2024/7/6 7:16:36

相关文章

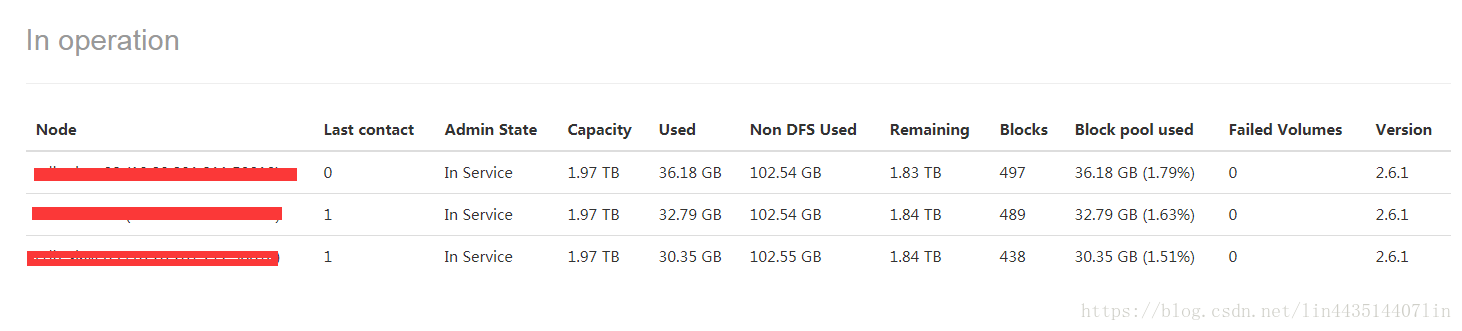

hadoop集群监控总结

1、取自ResourceManager REST API’s指标;

https://hadoop.apache.org/docs/r2.8.4/hadoop-yarn/hadoop-yarn-site/ResourceManagerRest.html

http://<rm http address:port>/ws/v1/cluster/metrics

http://**.**.***.208:8088/ws/v1/cluster/metrics

集群…

CDH5.15.0安装spark2.3

简介:

在我的CDH5.15.0集群中,默认安装的spark是1.6版本,这里需要将其升级为spark2.x版本。经查阅官方文档,发现spark1.6和2.x是可以并行安装的,也就是说可以不用删除默认的1.6版本,可以直接安装2.x版本&a…

java sqoop api 导mysql数据到hdfs

package com.example.demo.controller;import org.apache.hadoop.conf.Configuration;

import org.apache.sqoop.Sqoop;

import org.apache.sqoop.tool.SqoopTool;

import org.apache.commons.lang3.StringUtils;

/*** 创建人 **** 创建时间 2018/12/20*/

public class sqoopte…

centos安装mysql 在线安装

yum install mysql-server -y service mysqld start chkconfig mysqld on chkconfig --list mysqld

mysql 进入mysql命令行接口 mysql -u root; use mysql; select user, host, password from user; CREATE USER yishikeji% IDENTIFIED BY yishikeji; GRANT ALL PRIVILEGES ON…

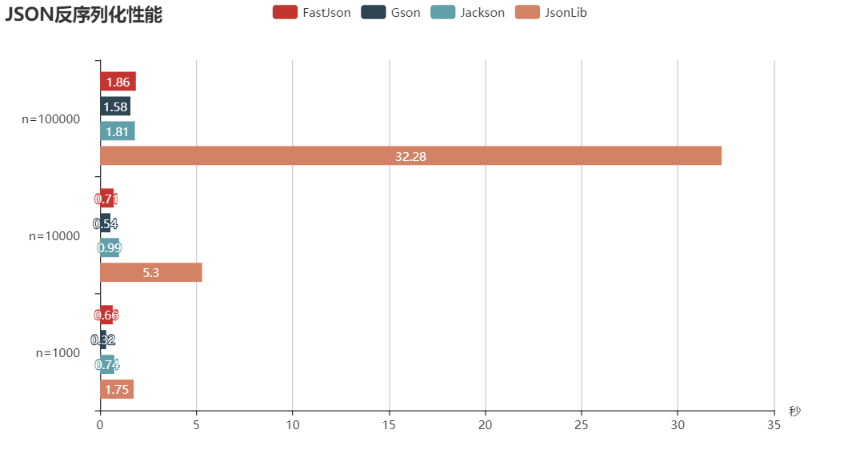

Java几种常用JSON库性能比较

SON不管是在Web开发还是服务器开发中是相当常见的数据传输格式,一般情况我们对于JSON解析构造的性能并不需要过于关心,除非是在性能要求比较高的系统。

目前对于Java开源的JSON类库有很多种,下面我们取4个常用的JSON库进行性能测试对比&…

我司Spark迁移Hive数据到MongoDB生产案例代码

github地址:https://github.com/yanglin502/sparkhivetomg/tree/master/sparkhivetomg

文章转自 若泽大数据:https://open.weixin.qq.com/connect/oauth2/authorize?appidwxc8cfdff818e686b9&redirect_urihttp%3A%2F%2Fkf.qq.com%2Ftouch%2Fsappfa…

代码 | Spark读取mongoDB数据写入Hive普通表和分区表

版本: spark 2.2.0 hive 1.1.0 scala 2.11.8 hadoop-2.6.0-cdh5.7.0 jdk 1.8 MongoDB 3.6.4

一 原始数据及Hive表

MongoDB数据格式

{"_id" : ObjectId("5af65d86222b639e0c2212f3"),"id" : "1","name" …

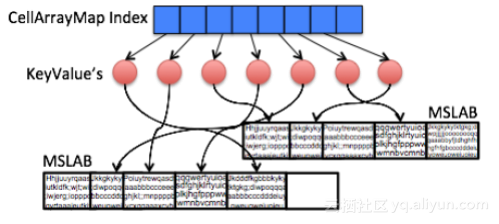

HBase2.0新特性之In-Memory Compaction

摘要: In-Memory Compaction是HBase2.0中的重要特性之一,通过在内存中引入LSM结构,减少多余数据,实现降低flush频率和减小写放大的效果。本文根据HBase2.0中相关代码以及社区的讨论、博客,介绍In-Memory Compaction的使…

最新文章

- Go 语言 Map(集合)

- linux 下neo4j的安装

- Unity中TimeLine的一些用法

- React面试题之setState的执行机制

- Apache Doris的分区与分桶原理解析

- 深入浅出:Linux 文件压缩与解压

- 守护线程与用户线程

- 【EOS钱包开发 一】EOS不得不说的一些概念

- FAQ:如何从URL取得其在Internet Cache中的文件名

- MultiMemberGZIPInputStream MmGz = new MultiMemberGZIPInputStream(fin);

- Please specify (single) host string for connection:

- Python实用技法第4篇:实现优先级队列